Il Benchmark di Scalabilità di n8n: Analisi Approfondita delle Prestazioni

Vi siete mai chiesti quali siano i limiti di n8n prima che raggiunga il punto di rottura? È stato condotto un test approfondito per spingere n8n al massimo delle sue capacità, rivelando risultati notevoli. Quando si gestiscono workflow critici, è fondamentale conoscere le proprie limitazioni. Recentemente, diverse configurazioni di n8n sono state sottoposte a prove rigorose, simulando traffico intenso e saturando le risorse per identificare le architetture più performanti. Che si tratti di un progetto personale o della gestione ingegneristica per una multinazionale, i test di stress sono essenziali per prevenire interruzioni, colli di bottiglia e problematiche inattese. Questa analisi del benchmark illustrerà il potenziale di n8n e i punti in cui le sue prestazioni iniziano a degradare.

Un Test Intenso per i Vostri Workflow

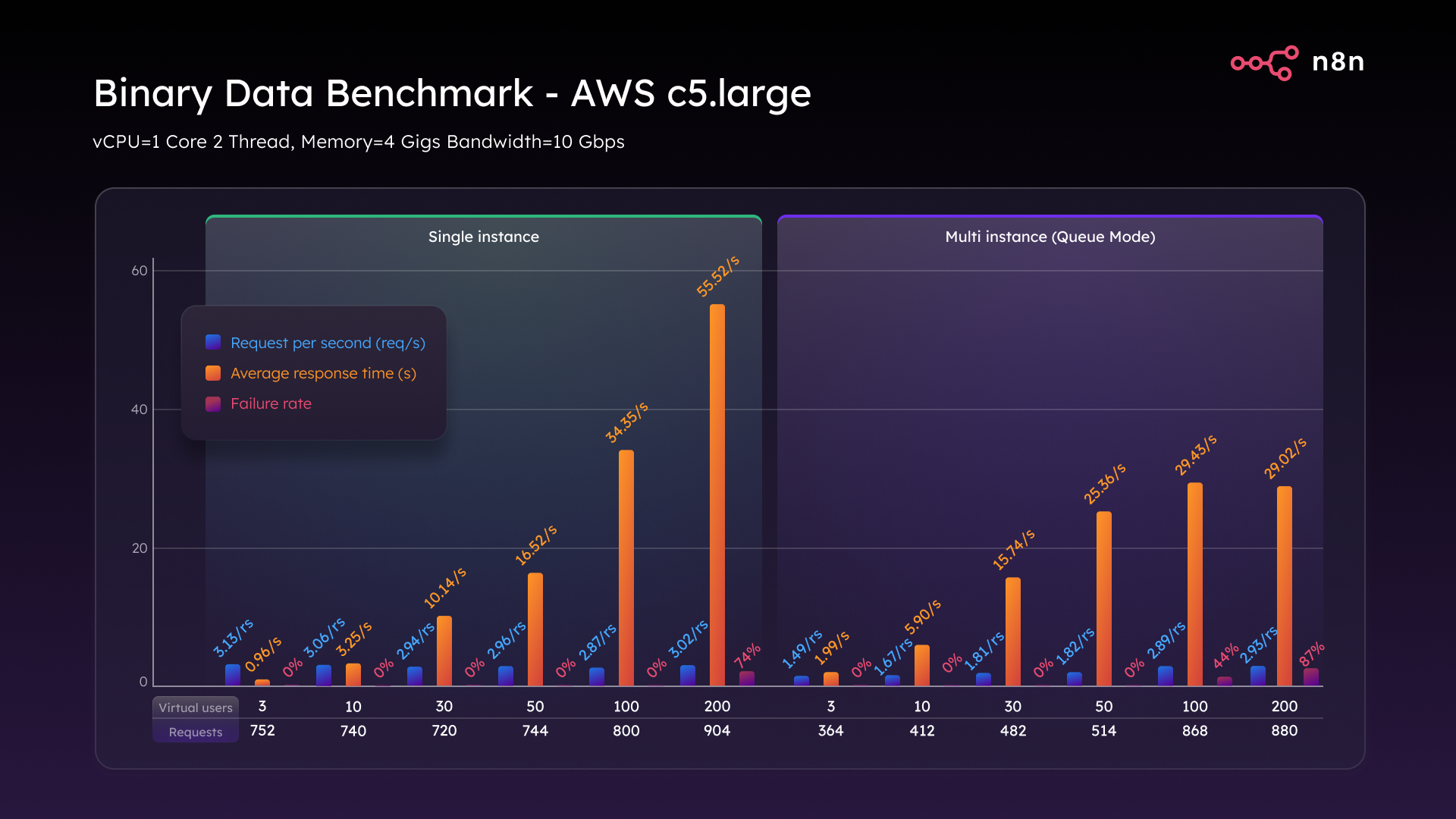

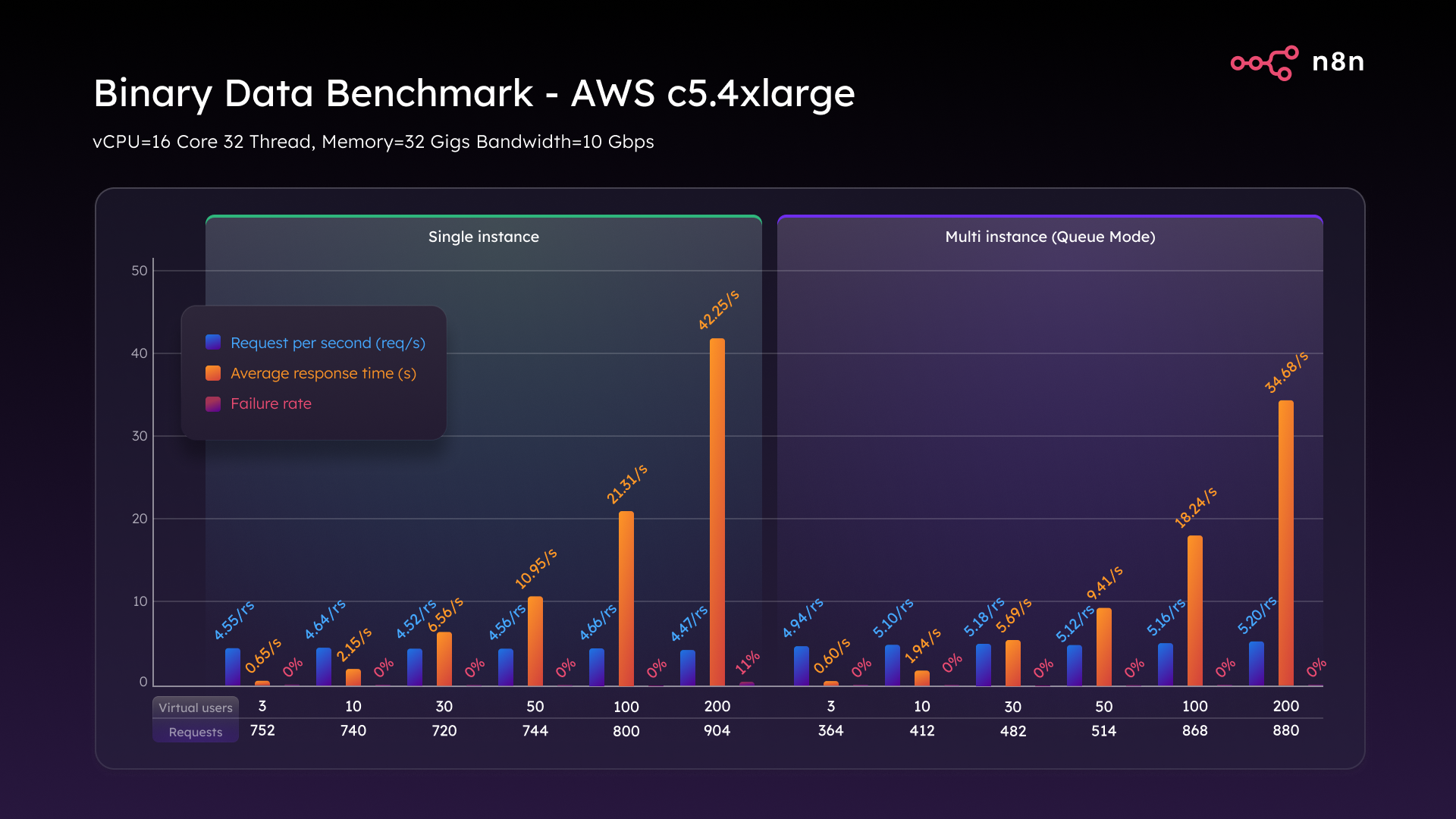

Per valutare la resistenza di n8n, sono stati condotti test di stress su due tipi di istanze AWS: C5.large e C5.4xlarge. Sono state impiegate entrambe le modalità di n8n, Single e Queue (un'architettura basata su code e multi-thread). Gli strumenti utilizzati includevano K6 per i test di carico, Beszel per il monitoraggio delle risorse in tempo reale e i workflow di benchmarking di n8n stessi per avviare automaticamente ogni scenario di stress.

Il workflow di test si basava su un foglio di calcolo per iterare attraverso diversi livelli di utenti virtuali (VU), eseguendo ogni test e registrando i risultati progressivamente. I dati raccolti sono stati poi trasformati in grafici per visualizzare gli indicatori chiave di performance. Inoltre, è stato possibile osservare in tempo reale le prestazioni del sistema sotto carichi variabili: la velocità di risposta, l'affidabilità nell'esecuzione e i punti critici.

La configurazione delle istanze AWS era la seguente:

L'istanza C5.large presentava:

- 1 vCPU

- 2 Thread

- 4 GB di RAM

- 10 Gbps di larghezza di banda

Scalando all'istanza C5.4xlarge, sono stati aggiunti 16 vCPU e 32 GB di RAM.

Sono stati eseguiti tre scenari di benchmark fondamentali:

- Webhook Singolo: un unico flusso attivato ripetutamente.

- Webhook Multiplo: dieci workflow attivati in parallelo.

- Dati Binari: caricamento ed elaborazione di file di grandi dimensioni.

Ogni test è stato scalato da 3 a 200 utenti virtuali per misurare:

- Richieste al secondo

- Tempo medio di risposta

- Tasso di fallimento sotto carico

Per chi fosse interessato a replicare questi test di stress, gli strumenti necessari sono disponibili pubblicamente, inclusi gli script di benchmark di n8n.

Webhook Singolo: I Primi Risultati

Il primo scenario ha simulato l'attivazione ripetuta di un singolo webhook, replicando l'invio di una richiesta a un server n8n e la ricezione di una risposta. L'obiettivo era capire fino a che punto una singola istanza n8n potesse essere spinta.

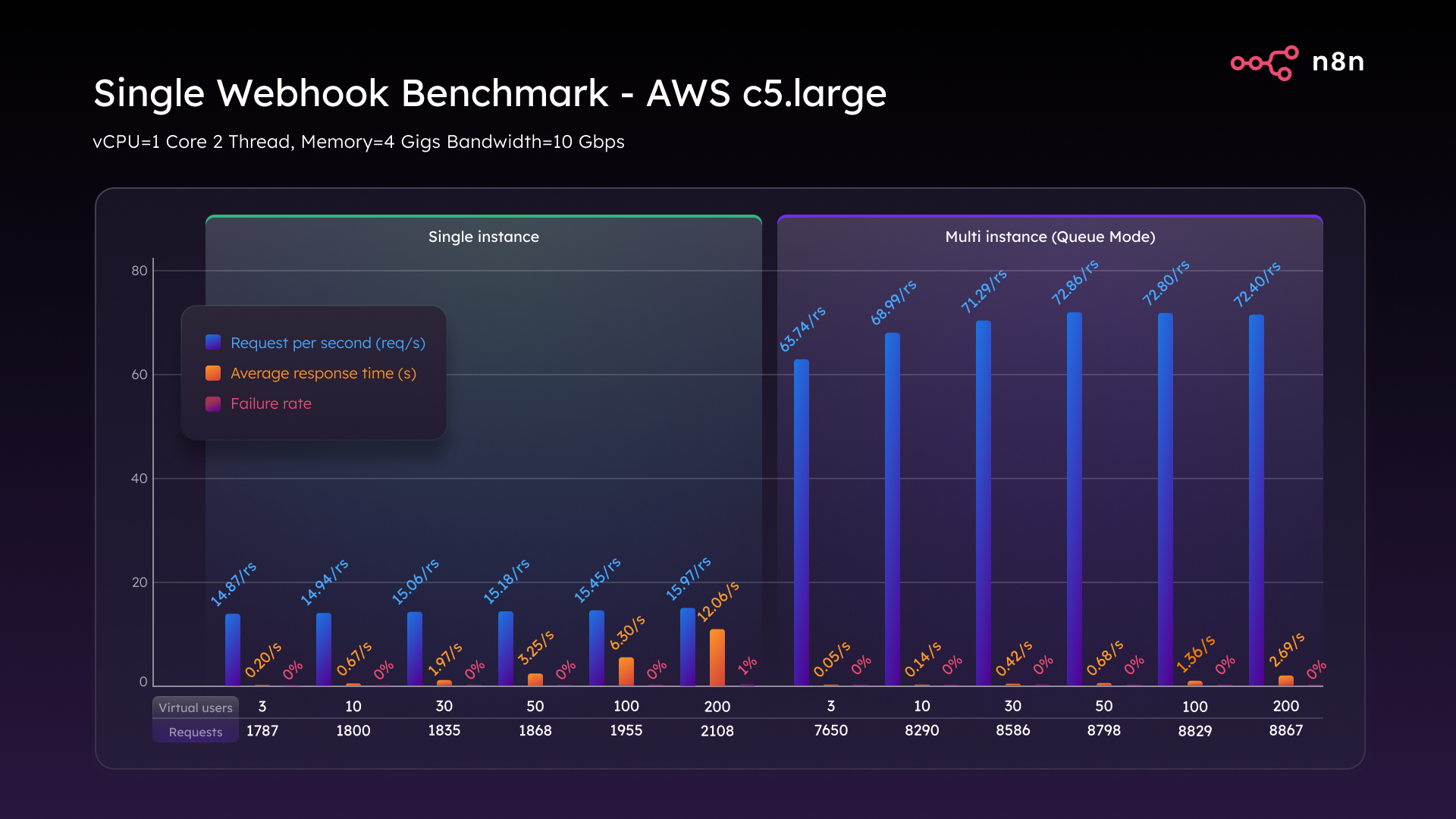

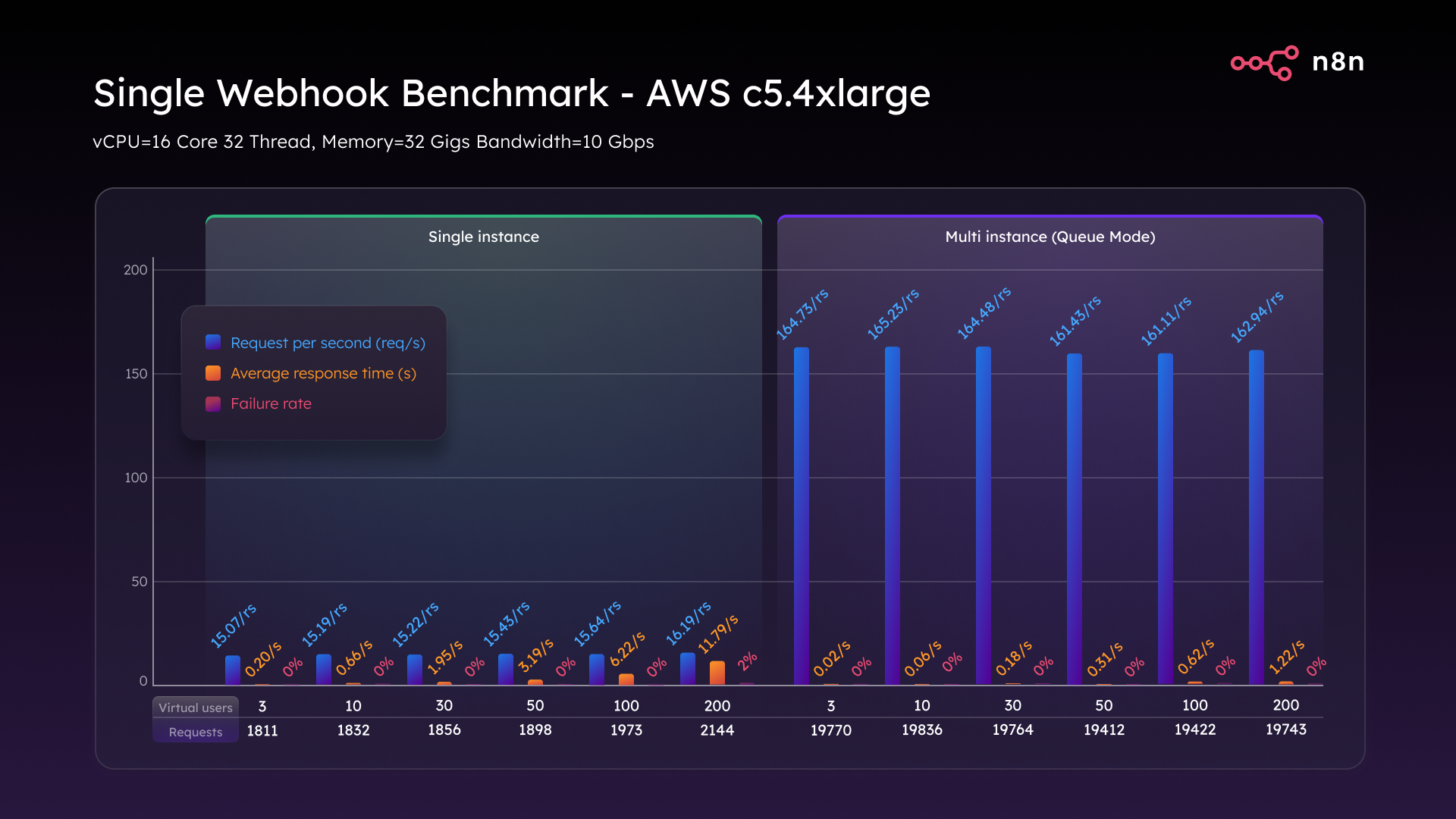

Su un'istanza AWS C5.large, la distribuzione di n8n in modalità Single ha gestito il carico in modo sorprendente. Sebbene l'istanza abbia resistito fino a 100 utenti virtuali (VU), raggiungendo i 200 VU si è evidenziato il limite di una configurazione single-thread, con tempi di risposta che hanno raggiunto i 12 secondi e un tasso di fallimento dell'1%.

L'attivazione della modalità Queue, un'architettura più scalabile di n8n che separa l'acquisizione dei webhook dall'esecuzione dei workflow, ha trasformato le prestazioni. Il sistema ha raggiunto 72 richieste al secondo, la latenza è scesa sotto i tre secondi e ha gestito 200 utenti virtuali senza alcun fallimento.

Scalando all'istanza C5.4xlarge (16 vCPU, 32 GB RAM), i miglioramenti sono stati notevoli. In modalità Single, il throughput è aumentato leggermente a 16.2 richieste al secondo, con modesti miglioramenti della latenza. Tuttavia, la modalità Queue ha mostrato prestazioni eccezionali, raggiungendo e mantenendo un flusso costante di 162 richieste al secondo con un carico di 200 VU, una latenza inferiore a 1.2 secondi e zero fallimenti. Questo rappresenta un incremento di throughput di 10 volte, ottenuto semplicemente scalando verticalmente e scegliendo l'architettura corretta.

Webhook Multiplo: La Gestione del Multitasking

Il test successivo ha mirato a simulare scenari di multitasking più complessi, tipici di implementazioni n8n in ambienti aziendali. Sono stati configurati dieci workflow distinti, ciascuno attivato dal proprio webhook.

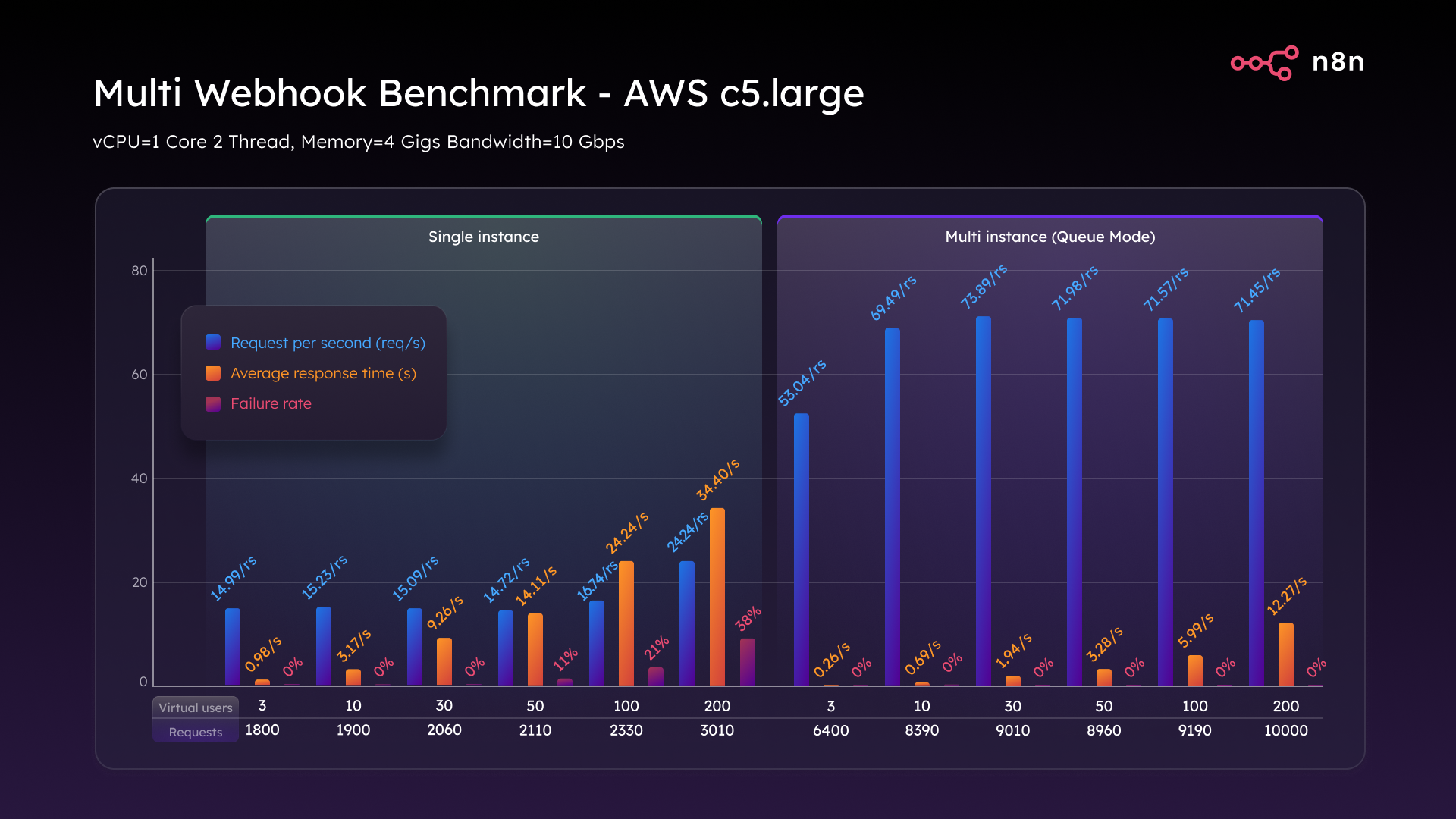

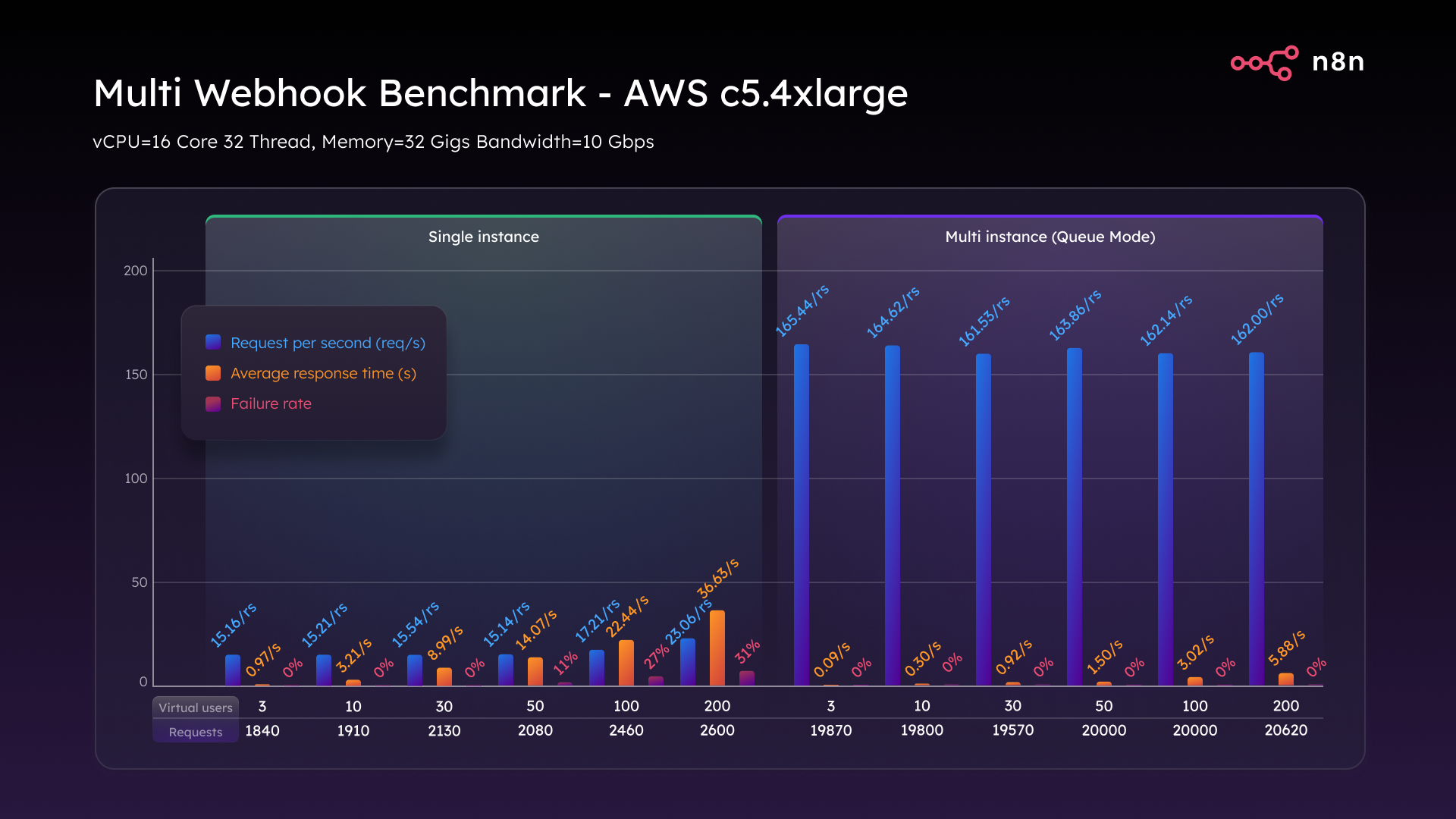

Sull'istanza C5.large in modalità Single, le prestazioni sono diminuite rapidamente. Con 50 VU, il tempo di risposta è salito sopra i 14 secondi, con un tasso di fallimento dell'11%. A 100 VU, la latenza ha raggiunto i 24 secondi e il tasso di fallimento il 21%. A 200 VU, il tasso di fallimento è arrivato al 38% e il tempo di risposta a 34 secondi, indicando un crollo quasi totale del sistema.

Il passaggio alla modalità Queue ha trasformato completamente la situazione. Il sistema ha sostenuto 74 richieste al secondo in modo costante, da 3 a 200 VU, mantenendo la latenza entro limiti accettabili e registrando un tasso di fallimento dello 0%. Lo stesso hardware ha prodotto un risultato drasticamente differente.

Ancora una volta, l'istanza C5.4xlarge ha elevato le prestazioni. In modalità Single, ha raggiunto un picco di 23 richieste al secondo con un tasso di fallimento del 31%. Tuttavia, in modalità Queue, ha gestito e mantenuto 162 richieste al secondo con qualsiasi carico, senza alcun fallimento. Anche sotto il massimo stress, la latenza si è mantenuta intorno ai 5.8 secondi. Il multitasking su larga scala richiede una maggiore potenza elaborativa, e la modalità Queue si è dimostrata estremamente efficace in tal senso.

Caricamento di Dati Binari: La Prova più Dura

L'ultimo test ha mirato a sollecitare n8n con le operazioni più esigenti in termini di RAM e I/O del disco, concentrandosi su workflow che gestiscono il caricamento di file di grandi dimensioni come immagini, PDF e contenuti multimediali.

Su un'istanza C5.large in modalità Single, le problematiche sono emerse precocemente. Con soli tre utenti virtuali, si sono registrate appena tre richieste al secondo. A 200 VU, i tempi di risposta sono esplosi e il 74% delle richieste è fallito, indicando un completo fallimento operativo.

La modalità Queue ha offerto una maggiore resilienza, ritardando il collasso. Tuttavia, anche in questa configurazione, a 200 VU, si è verificato un crollo con un tasso di fallimento dell'87% e payload incompleti.

Passando all'istanza C5.4xlarge, in modalità Single, si sono raggiunte 4.6 richieste al secondo, riducendo il tempo di risposta di un terzo e il tasso di fallimento dal 74% all'11%. Un miglioramento significativo, ma non ancora ottimale.

In modalità Queue, l'istanza C5.4xlarge ha raggiunto un picco di 5.2 richieste al secondo e, aspetto fondamentale, ha mantenuto un tasso di fallimento dello 0% per l'intera durata del test. Ogni file di grandi dimensioni è stato ricevuto, elaborato e gestito con successo. Questo test ha chiarito che non è solo una questione di architettura; i workflow intensivi con dati binari richiedono una notevole potenza di CPU, RAM e throughput del disco.

Conclusioni Chiave

Quali sono le principali lezioni apprese da questi approfonditi test?

- La modalità Queue è indispensabile. Rappresenta il primo passo fondamentale verso una scalabilità reale. Anche su hardware di base, migliora drasticamente le prestazioni con una configurazione minima.

- L'hardware è determinante. L'aggiornamento a un'istanza C5.4xlarge non solo raddoppia il throughput, ma dimezza anche la latenza ed elimina completamente i tassi di fallimento.

- I dati binari possono causare problemi se non gestiti adeguatamente. Per affrontarli, sono necessari più RAM, dischi più veloci, storage condiviso come S3 e worker paralleli.

Se state sviluppando automazioni per team interni, sistemi backend o applicazioni rivolte ai clienti, non aspettate che i colli di bottiglia vi costringano a un upgrade. Pianificate la scalabilità fin dall'inizio. Utilizzate la modalità Queue per separare l'acquisizione dall'elaborazione, scalate orizzontalmente con worker per l'elaborazione concorrente e dimensionate il vostro hardware in base al carico di lavoro. I flussi semplici richiedono meno risorse, ma i dati binari e il multitasking ne richiedono di più. n8n è progettato per scalare, ma come ogni motore, necessita del carburante e della configurazione giusti per esprimere la sua piena potenza.

Hai Bisogno di Supporto Professionale?

Se desideri un aiuto concreto per configurare n8n, progettare workflow complessi, migliorare sicurezza e scalabilità o integrare l’automazione con i tuoi sistemi esistenti, puoi affidarti a un supporto professionale.

Il nostro team può accompagnarti dalla prima installazione fino a soluzioni avanzate su misura per il tuo business.

👉 Contattaci su https://cyberrebellion.site/it per una consulenza personalizzata.

Strumenti per i Vostri Test di Scalabilità

Desiderate mettere alla prova la vostra configurazione? Ecco alcuni strumenti utili: